เจอนี่กับ Chat GPT: K-fold Validation

Credit: datacamp.com

ปกติผมจะใช้บริการ ChatGPT ก็ต่อเมื่อต้องรีบหาข้อมูลโดยเร็ว จะได้ไปทำอย่างอื่นต่อ หรือหาข้อมูลบน Google ไม่เจอสักทีจนหมดมุกกับ Key word ที่จะใช้แล้ว ซึ่งกรณีหลังก็จะได้ Key word ใหม่ๆ จาก ChatGPT ไปหาข้อมูลเพิ่มเพื่อตรวจคำตอบจาก ChatGPT อีกรอบ

รอบนี้หมดทั้งมุกทั้งเวลาที่หาคำตอบ คำถามก็คือ การใช้ K-Fold Cross validation แต่ละ Fold จะตั้งต้นจากการ Inertial Guest คำตอบก่อนทุกครั้ง หรือ Guest เฉพาะครั้งแรก ครั้งถัดมาก็เอาคำตอบจาก Fold ก่อนหน้ามาเป็นค่าเริ่มต้น ก็แอบเดาว่าน่าจะเป็นอย่างแรก แต่ก็ไม่พบแหล่งข้อมูลที่อธิบายกระบวนการนี้

เริ่มจากคำถามอุ่นเครื่องให้ ChatGPT ก่อน

You: what is cross validation in machine learning?

"ใน Machine Learning “corss validation” คืออะไร"

ChatGPT: Cross-validation is a technique used in machine learning to assess the performance and generalization ability of a model. The basic idea is to divide the dataset into multiple subsets, train the model on some of these subsets, and then evaluate its performance on the remaining subsets.

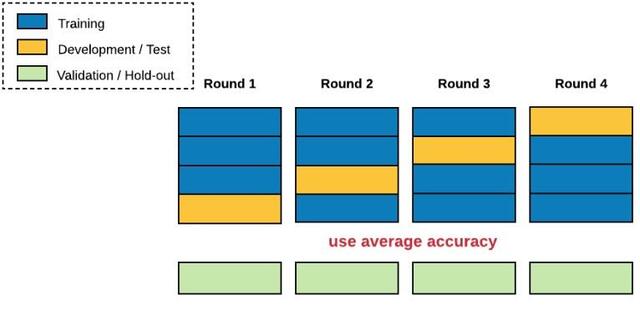

The most common form of cross-validation is k-fold cross-validation. Here's how it works:

Dataset Splitting: The dataset is divided into k subsets (or folds).

Training and Testing: The model is trained on k-1 of these folds and tested on the remaining one. This process is repeated k times, each time using a different fold as the test set.

Performance Metrics: The performance metrics (such as accuracy, precision, recall, etc.) are averaged over the k iterations to provide a more reliable estimate of the model's performance.

The main advantages of cross-validation include:

Robust Performance Estimation: It helps in obtaining a more reliable estimate of a model's performance by averaging over multiple train-test splits.

Reduced Variance: It reduces the variance of the evaluation by using multiple test sets rather than relying on a single partition of the data.

Model Generalization: It provides a better indication of how well the model will generalize to new, unseen data.

Keep in mind that the choice of k (the number of folds) can vary, but common values include 5 and 10. However, for smaller datasets, leave-one-out cross-validation (k equals the number of data points) can be used, although it can be computationally expensive.

In summary, cross-validation is a valuable technique in machine learning for evaluating a model's performance and assessing its ability to generalize to new data.

“Cross-validation เป็นเทคนิคที่ใช้ใน Machine Learning เพื่อประเมินสมรรถภาพและความเปิดกว้างของ model โดยมีแนวคิดพื้นฐานเป็นการแบ่งชุดข้อมูล ออกเป็นชุดย่อยหลายๆชุด แล้วใช้ส่วนชุดข้อมูลย่อยจำนวนหนึ่งมา สร้าง Model จากนั้นใช้ชุดข้อมูลย่อยที่เหลือมาทดสอบประสิทธิภาพของ Model

รูปแบบของ Cross-validation ที่นิยมใช้คือ K-Fold Cross-validation ซึ่งมีการทำงานดังนี้

- การแบ่งชุดข้อมูล: ชุดข้อมูลถูกแบ่งออกเป็น K ชุดย่อย (หรือ Fold)

- การ Train และการ Test: จำนวนชุดย่อย K-1 ชุด ถูกนำมาใช้ในการ Train อีก 1 ชุดย่อยที่เหลือถูกนำมาใช้ในการ Test กระบวนการนี้จะถูกทำซ้ำ K ครั้ง แต่ละครั้งจะใช้ชุดข้อมูลย่อยในการ Test ที่ไม่ซ้ำกัน

- Performance Metrics: Performance Metrics (เป็นชุดตัวเลขในการประเมิน เช่น ค่า accuracy, precision, recall ฯลฯ) เป็นค่าเฉลี่ยจากกระบวนการวนซ้ำ K ครั้งนี้ ทำให้ผลการประมาณสมรรถภาพของ model มีความน่าเชื่อถือสูง

ข้อดีของ Cross-validation ประกอบด้วย

- ความหนักแน่นของการประมาณสมรรถภาพของ model: ทำให้สามารถประมาณสมรรถภาพของ model มีความน่าเชื่อถือสูงจากการหาค่าเฉลี่ยในการทำ train-test splits หลายๆ ครั้ง

- ลดความผันแปร: ช่วยลดความผันแปรในการประเมินโดยใช้ Test set หลายชุด แทนที่จะใช้ข้อมูลย่อยเพียงชุดเดียว

- ความเปิดกว้างของ model: ช่วยปรับปรุงการชี้วัดความเปิดกว้างของ model ต่อข้อมูลใหม่ๆ ที่ model ไม่เคยพบมาก่อน ให้ดีขึ้น

ข้อควรตระหนักคือการเลือกค่า K (จำนวน Fold) สามารถปรับเปลี่ยนได้ โดยค่าที่นิยมใช้คือ 5 และ 10 อย่างไรก็ดี ชุดข้อมูลที่มีขนาดเล็ก วิธี leave-one-out cross-validation (k เท่ากับจำนวนข้อมูล) ก็อาจถูกพิจารณาใช้ได้ แม้ว่าจะมีการใช้ทรัพยากรณ์ในการคำนวณสูงก็ตาม

โดยสรุป cross-validation เป็นเทคนิคอันทรงคุณค่าของ Machine Learning ในการประเมินสมรรถภาพ และความเปิดกว้างของ model ต่อข้อมูลใหม่ที่มันไม่เคยเป็นมาก่อน"

ถามสั้นๆ แต่ Chat GPT ให้คำตอบที่ครบถ้วนสมบูรณ์เลยทีเดียว ดังนั้นคำถามถัดไป ผมยิงเข้าถึงข้อสงสัยแบบตรงๆ

You: In the case of linear regression k-fold cross validation, between each fold the algorithm start with new guest of weights and bias or from weights and bias from previous fold

“ในการทำ Linear Regression แบบ k-fold cross validation ในระหว่างแต่ละ fold ตัว algorithm จะเริ่มด้วยการเดาค่า weights และ bias ใหม่ หรือเอาค่า weights และ bias จาก fold ที่แล้วเป็นค่าเริ่มต้นในการคำนวณ”

ChatGPT: In k-fold cross-validation with linear regression, the model is trained and tested separately for each fold, and the weights and bias (coefficients) are typically reinitialized at the beginning of each fold.

Here's a step-by-step explanation:

Initialization: At the start of each fold, the weights and bias are initialized. This means that the linear regression model starts with a clean slate in terms of its parameters.

Training: The model is trained on k-1 folds of the dataset. During training, the algorithm adjusts the weights and bias to minimize the error on the training data.

Testing: The model is then tested on the remaining one fold. The performance metrics are computed based on the model's predictions on this test set.

Performance Recording: The performance metrics for that particular fold are recorded.

Weight Reinitialization: For the next fold, the weights and bias are once again initialized, and the process is repeated.

Average Performance: After all folds have been processed, the performance metrics are typically averaged over the k folds to obtain a more robust estimate of the model's performance.

This approach ensures that the model's performance is assessed in a fair and unbiased way for different subsets of the data. It also helps in evaluating how well the model generalizes to unseen data by testing it on multiple non-overlapping sets of samples.

In summary, in k-fold cross-validation, the model starts fresh with new weights and bias at the beginning of each fold, providing a fair evaluation across different partitions of the dataset.

“ในการใช้ k-fold cross validation กับ linear regression model จะถูก train และ test แบบแยกกันในแต่ละ fold โดยทั่วไป ในแต่ละ fold ค่า weights และ bias (ค่าสัมประสิทธิ์) ตอนเริ่มต้น จะถูก reinitialize ใหม่

โดยแต่ละขั้นตอนในการคำนวณเป็นดังนี้

- Inntialization: ในตอนเริ่มต้นของแต่ละ fold ค่า weights และ bias จะถูก initialize ใหม่ นั่นคือการสร้าง linear regression model จะเริ่มต้นที่ clean slate (ทำแบบล้างไพ่ใหม่หมด-ผู้เขียน) ในแง่ของ parameters

- Training: model ถูก train ด้วยชุดข้อมูลย่อยจำนวน k-1 fold ในระหว่างการ train ตัว algorithm จะปรับค่า weights และ bias เพื่อให้มี error ต่ำสุดกับ training data ที่ใช้

- Testing: model ถูกทดสอบด้วย 1 fold ที่เหลือ โดย performance metrics ถูกคำนวณจาก ผลการทำนายค่าของ model เทียบกับ test set นี้

- การบันทึกค่าสมรรถภาพ: Performance matrics เฉพาะแต่ละ fold จะถูกบันทึกไว้

- Weights reinitialization: ใน fold ถัดไป ค่า weights และ bias จะถูก initialized อีกครั้ง แล้วเริ่มกระบวนการคำนวณเดิมซ้ำ

- ค่า Performance โดยเฉลี่ย: เมื่อทุก fold ถูกนำมาประมวลผลจนหมด ค่า performance metrics จะถูกนำมาคำนวณค่าเฉลี่ย เพื่อให้เกิดการประมาณสมรรถภาพของ model ที่น่าเชื่อถือ”

"ด้วยวิธีดังกล่าว จึงมั่นใจได้ว่า สมรรถภาพของ Model ถูกประเมินอย่างถูกต้องโดยปราศจากความลำเอียงโดยใช้ชุดข้อมูลย่อยหลายชุด และยังช่วยในการประเมินความเปิดกว้างของ Model ต่อข้อมูบใหม่ๆ โดยทดสอบกับข้อมูลย่อยตัวอย่างหลายชุดที่ไม่มีชุดข้อมูลย่อยใดซ้อนทับกัน

โดยสรุป ในวิธี k-fold cross-validation model ถูกสร้างจากเริ่มด้วย weights และ bias ใหม่เสมอในแต่ละ fold ทำให้เกิดการประเมินอย่าถูกต้องด้วยส่วนต่างๆ ตลอดชุดข้อมูล"

จะเห็นว่า การให้คำตอบของ ChatGPT มีการตอกย้ำข้อดีของการใช้ Cross-validation จนผู้ถามรู้สึกมั่นใจในคำตอบ

ผมจึงลองจิ้มด้วยคำถามถึงผลบางอย่างที่ตามมาจากการ reinitialization ค่า weights และ bias ใหม่ทุก fold นั่นคือ

You: So, at the end of process, there is a set of weights and bias of each fold, isn't it?

“ดังนั้น ตอนจบกระบวนการ จะมีชุดคำตอบของ weights และ bias ของแต่ละ fold อยู่ ถูกต้องหรือไม่”

ซึ่ง ChatGPT ก็ตตอบแบบไม่ลังเล

ChatGPT : Yes, that's correct. At the end of the k-fold cross-validation process, you typically end up with a set of weights and bias for each fold. In each iteration, the model is trained with a different subset of the data, and as a result, the weights and bias are adjusted to best fit the training data for that particular fold.

After all k folds have been processed, you may have k sets of weights and bias. In practice, these sets of weights and bias are often discarded, and the final model is trained on the entire dataset using the optimal hyperparameters determined during the cross-validation process. The idea is to use the knowledge gained from the cross-validation to train a more robust and generalized model.

So, while you have sets of weights and bias for each fold, the final model parameters are typically determined by training the model on the complete dataset after the cross-validation process is complete.

“ChatGPT: ใช่ ถูกต้องแล้ว ในตอนจบกระบวนการแต่ละ fold จะจบลงด้วยชุดของ weights และ bias ของ fold นั้นๆ ในแต่ละวงรอบการคำนวณ model จะถูก train ด้วยชุดข้อมูลย่อยที่ต่างๆกัน ผลที่ตามมาคือ weights และ bias จะถูกปรับแต่งให้เหมะสมที่สุดกับชุดข้อมูลย่อยที่ใช้ train ในเฉพาะ fold นั้นๆ

หลังจากที่ชุดข้อมูลย่อยทั้ง k fold ถูกประมวลผลแล้ว คุณอาจมีชุดคำตอบที่เป็น weights และ bias อยู่ k ชุด โดยทั่วไป ชุดคำตอบทั้ง k ชุดนี้จะถูกละทิ้งไป (ไม่ถูกนำมาใช้ - ผู้เขียน) และ model สุดท้าย (ที่เป็นผลลัพธ์ - ผู้เขียน) จะเป็น model ที่ถูก train ด้วยชุดข้อมูลทั้งหมดด้วย Hyperparameters ที่เหมาะสมที่สุดซึ่งได้มาในช่วงระหว่างกระบวนการ cross-validation แนวคิดก็คือ การใช้ความรู้ที่ได้มาจากการทำ cross-validation ในการ train model ที่มีความทนทานและเปิดกว้างที่สุด

ดังนั้น ขณะที่คุณมีชุดของ weights และ bias ที่ได้จากการ train ในแต่ละ fold ท้ายที่สุด parameters ของ model ในตอนจบจะถูกคำนวณโดย train model (ใหม่) จากชุดข้อมูลทั้งชุดหลังจากกระบวนการ cross-validate เสร็จสิ้นอย่างสมบูรณ์ ”

นี่จึงเป็นสิ่งใหม่ที่ผมไม่เคยรู้มาก่อน ในตอนจบของการทำ cross-validation weights และ bias ของ model ถูกสร้างใหม่ด้วย dataset ทั้งหมด โดยไม่มีการทำ train-test-split เลย เพื่อความชัวร์ว่าเข้าใจถูกต้อง ผมจึงลองยิงคำถามแบบไม่ถูกต้อง เข้าไป

You: The final model you mention above, is trained by splitting data as train and test set as usual with the reinitialize weights and bias, is that right?

“Model สุดท้ายที่นายว่า ถูก train โดยการแบ่งข้อมูลเป็น train set และ test set พร้อมกับ weights กับ bias (เริ่มต้น -ผู้เขียน) ที่ถูก reinitialization ใหม่ตามที่เคยปฏิบัติมา ใช่หรือไม่”

และคำตอบจาก ChatGPT คือ

ChatGPT: No, the final model is trained on the entire dataset, and it doesn't involve a train-test split. After the k-fold cross-validation process, where the model is trained and evaluated on different subsets of the data, you've gained insights into the model's performance across various partitions.

Once you've completed the cross-validation, you train the final model using all the available data (not just a training subset) with the optimal hyperparameters determined during the cross-validation. This final training step is typically done to make the most use of the entire dataset and to obtain a model that has learned from the entire range of available examples.

The final set of weights and bias for the model is determined after training on the entire dataset, not through another train-test split. This ensures that the model has had the opportunity to learn from the full dataset and can potentially generalize better to new, unseen data.

"ไม่ใช่ model สุดท้ายถูก train ขึ้นจากชุดข้อมูลทั้งชุด โดยไม่ทำการแบ่งข้อมูลเป็น train-test split หลังเสร็จสิ้นกระบวนการ k-fold cross-validation ซึ่ง model ถูก train และประเมินด้วยชุดข้อมูลย่อยที่ต่างๆ กันแล้ว ทำให้คุณมองเห็นเบื้องลึกของ สมรรถภาพ ของ model ตลอดทุกส่วนย่อยต่างๆ (ของชุดข้อมูล - ผู้เขียน)

เมื่อคุณเสร็จสิ้นกระบวนการ cross-validation อย่างสมบูรณ์ คุณสามารถ train model สุดท้ายออกมาโดยใช้ข้อมูลทั้งหมดที่มี (โดยไม่ต้องแบ่งเป็นชุดย่อยเพื่อการ train) ด้วย Hyperparameters ที่เหมาะสมที่สุด ซึ่งหามาได้ในช่วงทำการ cross-validation ขั้นตอนสุดท้ายในการ train นี้ โดยทั่วไปจึงทำโดยใช้ชุดข้อมูลทั้งหมด เพื่อสร้าง model ที่เรียนรู้จากชุดข้อมูลตัวอย่างทั้งหมดที่มี

ชุดของ weights และ bias สุดท้ายของ model ที่คำนวณได้โดยใช้ชุดข้อมูลทั้งหมดโดยไม่ทำการ train-test split เป็นการทำให้แน่ใจว่า model ได้มีโอกาศเรียนรู้ (คือถูกสร้างขี้น-ผู้เขียน) จากชุดข้อมูลเต็มรูปทั้งหมด และมีศักยภาพในความเปิดกว้างที่ดีขึ้นต่อข้อมูลใหม่ที่ไม่เคยเห็นมาก่อน"

จะเห็นว่า ChatGPT ให้คำตอบแบบเน้นย้ำหนักแน่น ซึ่งในทางจิตวิทยา ผู้ใช้งานบางคนอาจถูกตอกย้ำจนมั่นใจในคำตอบ

ผมยังไม่มีโอกาศได้ตรวจสอบความถูกต้องของคำตอบทั้งหมดจาก ChatGPT หวังว่าท่านผู้อ่านจะพอมีเวลาช่วยผมตรวจสอบคำตอบจากแหล่งข้อมูลที่เชื่อถือได้ เป็นนำมาแบ่งปันกันครับ

ความเห็น (1)

I like your experiments but feel that the answers are ‘on the input side’. It would be interesting to validate the answers ‘on the output side’. Perhaps by other AI models (Bard, Copilot, Gemini,…)?